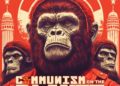

La métaphore ne dit pas que Google manipule ses clients. Elle illustre la mécanique d’une dépendance collective. Nous ne sommes pas tombés dedans malgré nous. Nous avons plongé avec enthousiasme. Et la politique arrive une fois de plus après la bataille.

Une offre séduisante, un accès sans friction

Google propose aujourd’hui un accès gratuit à Gemini, suffisamment performant pour des millions de particuliers. L’offre Gemini Advanced élargit les capacités pour un coût maîtrisé. Dans le cadre professionnel, Google signe un module professionnel baptisé Google Workspace AI Premium, intégré au cœur des outils de travail, injectant l’IA dans Gmail, Docs, Sheets, Slides. Quant à l’API Gemini, elle structure déjà une partie du travail des développeurs et des entreprises.

Tout cela représente des faits, facilement vérifiables. Aucun piège tarifaire, aucun signe de hausse orchestrée. Le marché reste même très compétitif. La première dose du dealer métaphorique est simplement un service efficace, bien emballé et proposé à un prix raisonnable. C’est exactement pour cela que la dépendance naît. La politique de la facilité n’a pas besoin de complot. Elle s’alimente de notre besoin de simplification.

Le pouvoir réel ne vient pas du prix, mais de l’habitude. Le jour où l’on supprime cet outil, on retire une béquille cognitive devenue essentielle. C’est ce vide qui crée la dépendance.

Une dépendance fonctionnelle devenue un fait social

Les usages s’installent partout. Étudiants, journalistes, marketeurs, fonctionnaires, PME, retraités, créateurs de contenu… Chacun intègre l’IA dans son geste quotidien. Pas pour tricher, mais pour accélérer. Pas pour remplacer, mais pour alléger. Ce glissement vers l’assistance se déroule sans résistance parce que l’outil apporte une forme de soulagement mental. Le dealer numérique ne distribue pas un produit interdit. Il distribue du confort.

Les institutions avancent à la même vitesse que les individus. Des administrations testent l’IA pour résumer des textes. Des collectivités l’utilisent pour rédiger des rapports. Des écoles s’y appuient pour corriger, préparer ou illustrer. En moins de deux ans, l’IA s’est infiltrée dans l’appareil administratif sans qu’aucun débat démocratique structuré n’ait réellement eu lieu.

Cette dépendance fonctionnelle construit un rapport de force inédit. L’utilisateur croit tenir l’outil. En réalité, c’est l’outil qui tient l’utilisateur par ses usages les plus quotidiens. Et le politique suit derrière, essoufflé.

Un pouvoir privé sur un espace public

Le cœur du problème dépasse largement la question des prix. On ne sait pas si Google augmentera les tarifs. Mais gardons en mémoire que toute industrie mature ajuste ses revenus un jour ou l’autre. Mais le débat intéressant se situe ailleurs dans la nature du pouvoir qu’un tel acteur détient désormais.

Google influence déjà la circulation de l’information à grande échelle avec son moteur de recherche. Désormais, l’entreprise influence aussi la production de l’information, en générant textes, idées, résumés, arguments. Ce n’est plus une infrastructure. C’est une couche cognitive.

Quand un acteur privé fournit gratuitement ou presque l’accès à une technologie qui restructure notre pensée, la politique ne peut pas rester spectatrice. L’IA devient un espace public. Pourtant, son fonctionnement reste entre les mains d’organisations qui ne répondent ni à un suffrage, ni à un contrôle démocratique, ni à une obligation de transparence totale.

Le dealer métaphorique illustre ce déséquilibre où l’État regarde pendant que l’usager s’habitue. Et celui qui fournit la substance cognitive prend une position de force, non par intention malveillante, mais par inertie du système.

Le risque réel d’un basculement invisible

Mais revenons à la hausse. Une hausse, même légère, aurait un impact massif, car nos usages sont déjà ancrés. C’est ici que la métaphore du dealer trouve sa pertinence et le produit ne devient indispensable qu’après avoir été utilisé longtemps. Et une fois indispensable, il devient une zone de vulnérabilité.

Le risque politique ne réside pas dans une hausse tarifaire hypothétique. Il réside dans l’absence totale de plan B. Aucune institution publique ne propose une alternative souveraine crédible à Gemini, ChatGPT, Claude ou Copilot. Toutes nos administrations dépendent de fournisseurs privés américains pour réfléchir plus vite, produire plus vite, décider plus vite. Cette dépendance structurelle devient un enjeu de souveraineté. Elle transforme chaque progrès individuel en fragilité collective. Le dealer n’a pas besoin d’augmenter les prix pour tenir la rue. Il suffit que la rue n’ait aucune autre source d’approvisionnement.

L’IA s’est imposée sans débat, sans stratégie nationale claire, sans régulation suffisamment anticipée. L’Europe tente de poser un cadre avec l’AI Act, mais le rythme politique reste en décalage complet avec la vitesse technologique. Les géants privés agissent vite, avec cohérence et vision. Les États réagissent lentement. Un pays qui confie son accès à la connaissance, sa productivité, son innovation, sa créativité et sa bureaucratie à une poignée d’entreprises étrangères s’expose à une fragilité majeure. L’histoire récente du numérique l’a montré : une dépendance technique devient rapidement une dépendance politique.

Le modèle du dealer n’est qu’un miroir grossissant. Il montre ce que nous faisons subir à notre propre démocratie en acceptant que l’essentiel de notre vie cognitive soit sous-traité à des acteurs privés. Et c’est bien là le problème. Google ne piège personne. Google propose. Nous acceptons. Et nous construisons une dépendance collective sans anticipation. Le danger ne vient pas d’une stratégie cachée, mais de notre incapacité à structurer un contre-pouvoir. Le rôle du politique devrait consister à garantir un accès équitable, pérenne, souverain à l’intelligence artificielle. Pour l’instant, ce rôle reste vacant.

Antoine GARCIA